篡改的医学图像可以欺骗人工智能和放射科医生

12月14日发表在Nature Communications上的研究显示,在阅读图像方面,人工智能与放射科医生的较量还没有定论,但如果图像被篡改,两者都可能被骗。

包括来自中国浙江大学的第一作者Qianwei Zhou博士和匹兹堡大学的资深作者Shandong Wu博士的团队发现,一个人工智能模型被超过三分之二的假乳房图像所欺骗,使它们容易发生网络攻击并强调人工智能安全措施的必要性。

"从诊断的角度来看,诊断敏感内容的成像特征对于研究人员和临床医生构建鲁棒而安全的医学成像诊断AI系统具有特别的相关性和重要性 "吴告诉AuntMinnie.com。

近年来,人工智能作为第二阅片者检测乳腺癌的潜力不断增长,研究表明两者可以在临床环境中共存。

然而,人工智能也面临着网络攻击的风险,例如基于生成对抗网络(GAN)算法的攻击。不易察觉的噪音可以被添加到图像中,新的图像可以被添加以取代真实的图像,或者对真实图像进行有针对性的修改。研究人员说,当被篡改的图像被送入人工智能模型时,这些攻击可能会导致意外的、假的、或错误的诊断结果。

Zhou博士等人想找出使用乳房X光检查图像开发检测乳腺癌的AI模型在这些复杂的对抗性攻击下的表现。研究作者称这是人工智能对可信的对抗性攻击的安全评估的一个 "关键测试"。

他们写道:“了解AI诊断模型在对抗性攻击下的行为将有助于获得识别网络安全漏洞和开发潜在防御此类攻击的机制的重要洞察。”。

该小组训练了一种深度学习算法,以超过80%的准确率区分癌性和良性病例。该小组还开发了一种GAN算法,从阴性或阳性图像中插入或删除癌症区域。然后人工智能模型对这些对抗性图像进行分类。

周博士和他的同事发现该模型被 69.1% 的假乳房图像所欺骗。对抗网络制作的44张阳性病例但看起来很像阴性病例的图像中,42张被模型归类为阴性。在319张看起来呈阳性的阴性病例图像中,209张被归类为阳性。

这项研究的结果与五名被要求区分假乳房X光片和真实图像的放射科医生的结果进行了比较。根据放射科医生的不同,他们的准确率在29%到71%之间。

参与研究的放射科医生对研究结果以及医学诊断人工智能可能受到的干扰感到非常惊讶,”吴说。

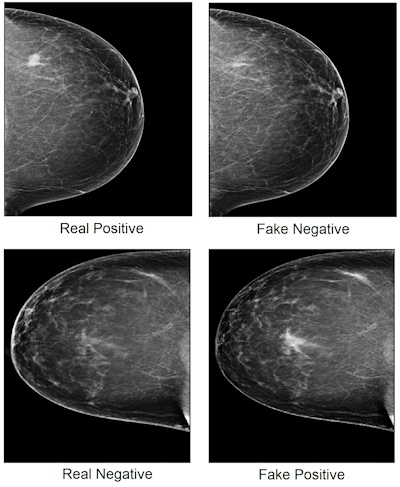

显示真实的癌症阳性和癌症阴性病例的乳房X光检查图像

乳房X光照片显示真实的癌症阳性(左上)和癌症阴性(左下)病例,癌组织显示为白点。生成性对抗网络程序从癌症阳性图像中删除癌区,创建假阴性图像(右上角),并将癌区插入癌症阴性图像,创建假阳性图像(右下角)。图像由Qianwei Zhou博士等在Nature Communications提供。

吴博士告诉AuntMinnie.com,该团队正开始致力于开发针对医学成像领域的对抗性攻击的潜在防御方法和策略。作者写道,在这个阶段,人类专家在检测可疑的对抗性输入方面仍然是 "一个关键角色"。然而,他们补充说,教育干预和工具是 "非常需要的"。

我们的实验表明,通过先进的生成对抗性网络算法,可以在乳房X光片图像上生成高度可信的对抗性样本,并且它们可以诱导深度学习AI模型输出乳腺癌的错误诊断,”他们说。

本篇为新闻译文,全篇原文发表于AuntMinnie.com,作者为该网站特约撰稿人Amerigo Allegretto